Blog-Eintrag -

KI in Unternehmen: Mit spezialisierten Fachkräften zum Erfolg

Die strategischen Schlüsselrollen für erfolgreiche KI- und Big-Data-Initiativen

Datenanalyse als Wettbewerbsvorteil

In der heutigen Geschäftswelt werden Datenanalyse und datengestützte Entscheidungen immer mehr zum entscheidenden Wettbewerbsvorteil. McKinsey-Studien belegen, dass Unternehmen, die KI-Technologien effektiv einsetzen, ihre Gewinnmargen deutlich steigern können. Doch während die Menge an verfügbaren Daten exponentiell wächst, verfügen viele Unternehmen nicht über die richtigen Strukturen, um diesen Schatz zu heben.

Die Herausforderung: Immer mehr Systeme generieren immer mehr Daten. Von CRM und ACD-Anlagen bis hin zu Ticketing-Systemen. Diese Daten liegen häufig verteilt vor und werden nicht optimal oder gar nicht genutzt. Die gute alte Excel-Tabelle stößt hier längst an ihre Grenzen. Um das volle Potenzial von Big Data und künstlicher Intelligenz auszuschöpfen, braucht es spezialisierte Rollen und klare Strukturen.

Dieser Artikel wirft einen tieferen Blick in die Software & Data Intelligence und zeigt auf, welche Fachkräfte in professionellen KI & Big Data Initiativen zum Einsatz kommen, welche Aufgaben sie in ihrer jeweiligen Rolle übernehmen und was sie an Skills, Mindset oder Tools benötigen. Natürlich stellen wir am Ende auch die Frage aller Fragen: Wen benötigt man für den Einsatz von KI in Unternehmen denn wirklich?

Ein modernes Contact Center als Beispiel

Stellen wir uns ein modernes Contact Center vor: Das Ziel ist, Kundenanliegen über verschiedene Kanäle hinweg effizient und fallabschließend zu bearbeiten. Dafür müssen Agenten schnell auf alle relevanten Kundeninformationen zugreifen können – von der Kauf- und Servicehistorie bis hin zu früheren Notizen und Reparaturaufträgen. Gleichzeitig sollen Wartezeiten minimiert werden, ohne dabei wirtschaftliche Aspekte zu vernachlässigen, was ein genaues Forecasting und effiziente Personaleinsatzplanung unabdingbar macht.

Die klassische Herangehensweise und ihre Grenzen

In vielen Unternehmen sieht das typische Vorgehen zur Datenanalyse noch immer so aus:

- Daten werden aus verschiedenen Quellsystemen extrahiert und teilweise manuell in Excel-Tabellen zusammengeführt

- Reports werden von verschiedenen Abteilungen separat erstellt und ausgewertet

- es existieren Datensilos ohne übergreifende Strategie zur Datennutzung

- Analysen werden reaktiv durchgeführt, statt proaktiv Trends zu erkennen

Die zentralen Rollen in diesem klassischen Modell sind oft auf Datenbankadministratoren und Excel-Experten beschränkt. Dieses Vorgehen führt zu erheblichen Nachteilen: zeitaufwändige manuelle Prozesse, hohe Fehleranfälligkeit, widersprüchliche Daten, mangelnde Aktualität und kaum Möglichkeiten für tiefergehende, prädiktive Analysen.

Der moderne Ansatz: Data Lake und strukturierte Prozesse

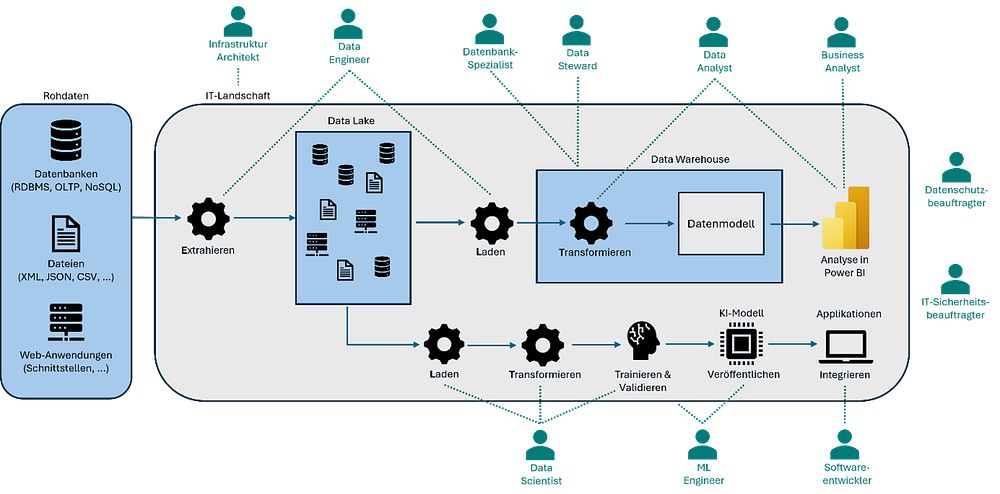

Für eine zukunftsfähige Nutzung von Big Data und KI in Unternehmen empfiehlt sich ein strukturierter Ansatz, der auf einer zentralen Datenarchitektur und klar definierten Rollen basiert:

Ein Data Lake bildet dabei das zentrale Repository, den zentralen Speicherort, der große Datenmengen in ihrer ursprünglichen Form erfasst, speichert und verarbeitet. Es kann alle Arten von Rohdaten aus beliebigen Quellen aufnehmen, von strukturierten (Datenbanktabellen, SQL) über halbstrukturierte (XML, JSON, NoSQL) bis hin zu unstrukturierten Daten (Bilder, Audiodateien).

Für Auswertungen werden diese Daten oft in einem Datawarehouse in einer für Abfragen optimierten Form abgelegt. Statt der normalisierten Form kommen häufig Strukturen wie Stern- oder Schneeflockenschema zum Einsatz. Um Daten in den Data Lake zu speichern und im Datawarehouse vorzubereiten, werden ETL- (Extract, Transform, Load), ELT- oder ETLT-Prozesse implementiert. Aktuelle Trends gehen zu hybriden Ansätzen in Form von Lake Warehouses.

Für Analysen bieten sich außerdem Business-Intelligence-Tools an, wie bspw. Tableau, Qlik, oder Microsoft Power BI.

Big Data und KI in Unternehmen kompetent anwenden

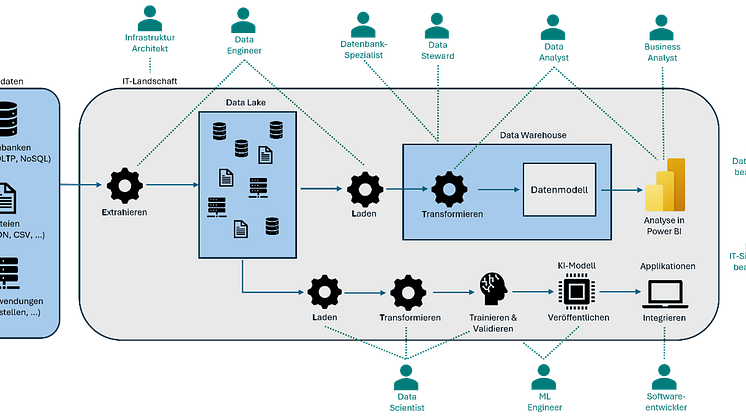

Für den Umgang mit komplexen Big Data Szenarien benötigt ein Unternehmen diverse Kompetenzen, welche sich in Form einzelner Rollen darstellen lassen. Schauen wir uns beispielsweise einen vereinfachten ELT-Vorgang an, bei dem Rohdaten zunächst in einem Data Lake gesammelt und später für einen konkreten Analysezweck transformiert und in ein Datawarehouse übertragen werden.

Es wurde hier das ELT-Konzept gewählt, damit die Rohdaten neben der bloßen Analyse auch für andere Anwendungszwecke, wie dem Trainieren eines KI-Modells, zentral verfügbar sind. Allein in diesem vereinfachten Prozess könnten effektiv mindestens vierzehn verschiedene Schlüsselrollen beschäftigt werden, die wir uns nachfolgend im Detail anschauen.

1. Die Schlüsselrollen für die technische Basis

Die technische Basis bildet das Fundament jeder Initiative, bei der Datenanalyse oder KI in Unternehmen eingesetzt werden soll. Sie umfasst alle Komponenten, die notwendig sind, um Daten zu sammeln, zu speichern und für Analysen verfügbar zu machen. Ohne eine solide technische Infrastruktur können selbst die besten Analysemodelle nicht erfolgreich implementiert werden.

Dafür arbeiten die drei Rollen Infrastruktur Architekt, Data Engineer und Datenbankspezialist / -administrator eng zusammen, um eine skalierbare, performante und sichere Dateninfrastruktur aufzubauen. Während Infrastruktur-Architekten die grundlegende Plattform bereitstellen, sorgen Datenbankspezialisten für optimale Datenstrukturen und Data Engineers für den effizienten Datenfluss zwischen den Systemen.

Infrastruktur Architekt (m/w/d)

- Aufgabe: Bereitstellung und Sicherung der Plattform

- Mindset: zukunftsorientiert, sicherheitsbewusst, pragmatisch

- Skillset: Cloud, Netzwerk, Systemintegration, Skalierung, Virtualisierung

- Tools: Microsoft Azure, AWS, Google Cloud, Terraform, Ansible, Docker, Kubernetes

Datenbankspezialist / -administrator (m/w/d)

- Aufgabe: Design und Optimierung von Datenbanken

- Mindset: strukturiert, detailorientiert, effizienzfokussiert, sicherheitsbewusst

- Skillset: Datenmodellierung, SQL & NoSQL, Datenbankoptimierung, Hochverfügbarkeit

- Tools: Azure SQL Server, Microsoft SQL Server, MongoDB, Databricks

Data Engineer (m/w/d)

- Aufgabe: Erstellung und Wartung von Datenpipelines

- Mindset: qualitätsbewusst, prozessorientiert, automatisierungsfokussiert, pragmatisch

- Skillset: SQL & NoSQL, Programmierung (OOP), ETL/ELT, Big-Data-Technologien

- Tools: Azure Data Factory, Apache Spark, Hadoop, Microsoft Fabric, Powershell, VS Code

2. Die Schlüsselrollen für explorative und deskriptive Analyse (Visualisierung)

Der Bereich der explorativen und deskriptiven Analyse verwandelt rohe Daten in wertvolle Geschäftserkenntnisse. Die dafür eingesetzten Schlüsselrollen sind die Brücke zwischen technischen Datenstrukturen und konkreten Geschäftsentscheidungen. Sie machen komplexe Zusammenhänge durch Visualisierung und Interpretation verständlich und ermöglichen so eine fundierte, datengetriebene Unternehmenssteuerung.

Die Stärke dieser Rollen liegt in ihrer komplementären Ausrichtung: Data Analysten können aus großen Datenmengen relevante Muster erkennen, Business Analysten stellen den Bezug zu Geschäftsprozessen her, und BI-Spezialisten sorgen dafür, dass die gewonnenen Erkenntnisse in leicht verständlichen, regelmäßig aktualisierten Berichten und Dashboards verfügbar sind.

Data Analyst (m/w/d)

- Aufgabe: Analyse und Interpretation von Daten zur Beantwortung von Geschäftsfragen

- Mindset: analytisch, lösungsorientiert, neugierig

- Skillset: SQL, Datenvisualisierung, Python / R

- Tools: Microsoft Power BI, Tableau, Qlik, SQL Server Management Studio

Business Analyst (m/w/d)

- Aufgabe: Übersetzung von Geschäftsanforderungen in Datenanalyseprobleme und Interpretation der Ergebnisse

- Mindset: analytisch, lösungsorientiert, neugierig, kommunikativ

- Skillset: Anforderungsanalyse, Prozessoptimierung, Domänenwissen / KPIs, Präsentationsfähigkeiten

- Tools: Excel und Office-Produkte, Projektmanagement-Tools

BI-Spezialist (m/w/d)

- Aufgabe: Entwicklung und Pflege von Dashboards und Reports, Bereitstellung von Self-Service-BI-Lösungen

- Mindset: analytisch, nutzerorientiert, qualitätsbewusst, strukturiert

- Skillset: ETL/ELT (Low-Code), SQL, Domänenwissen / KPIs, Datenvisualisierung

- Tools: Microsoft Power BI, Tableau, Qlik, SQL Server Management Studio

3. Die Schlüsselrollen für prädiktive oder präskriptive Analysen (KI und ML)

Während deskriptive Analysen die Frage Was ist passiert? beantworten, fokussieren sich prädiktive und präskriptive Analysen auf Was wird passieren? und Was sollten wir tun?. Diese fortgeschrittenen Analysemethoden nutzen maschinelles Lernen (ML) und künstliche Intelligenz (KI), um Vorhersagen zu treffen und Handlungsempfehlungen abzuleiten. Sie bilden den Kern moderner KI-Anwendungen im Unternehmensumfeld.

Die Zusammenarbeit zwischen Data Scientists und ML Engineers ist entscheidend für den Erfolg von KI-Projekten. Während Data Scientists sich auf die statistische Modellierung und die Entwicklung innovativer Algorithmen konzentrieren, sorgen ML Engineers dafür, dass diese Modelle robust, skalierbar und in Produktivumgebungen einsatzfähig sind. Diese Arbeitsteilung ist besonders in größeren Unternehmen wichtig, wo KI-Lösungen in komplexe IT-Landschaften integriert werden müssen.

Data Scientist (m/w/d)

- Aufgabe: Entwicklung von Analyse-Modellen aus vorbereiteten Daten , Implementierung von Predictive Analytics und KI-Modellen (z.B. Forecasting), kontinuierliche Validierung und Optimierung der Modelle

- Mindset: experimentierfreudig, hypothesengetrieben, analytisch

- Skillset: Statistik & Machine Learning, Programmierung, Feature Engineering, Modellvalidierung und -optimierung

- Tools: Python (scikit-learn, TensorFlow, PyTorch), R, ML.NET, Azure Machine Learning

ML Engineer (m/w/d)

- Aufgabe: Konzentriert sich auf das Feature Engineering, also die Aufbereitung der Daten für ML-Modelle, Implementiert Machine Learning-Pipelines, Kümmert sich um das Training, die Bewertung und den Betrieb von ML-Modellen, Sorgt für die Produktionsreife der Algorithmen

- Mindset: lösungsorientiert, qualitätsbewusst, skalierungsfokussiert

- Skillset: Software Engineering, Machine Learning-Algorithmen, Deployment-Technologien

- Tools: Python (TensorFlow), Docker, Kubernetes, CI/CD-Tools

4. Die Schlüsselrollen für die Integration

Der Bereich Integration stellt sicher, dass Datenanalysen und KI-Modelle nicht nur theoretische Konzepte bleiben, sondern in die bestehenden Systeme und Geschäftsprozesse eingebunden werden. Diese Rollen übersetzen Analysen und Modelle in konkrete Anwendungen, die von Endnutzern tatsächlich genutzt werden können und einen messbaren Mehrwert für das Unternehmen schaffen.

Das Integrationsteam bildet die Brücke zwischen komplexen Datenmodellen und tatsächlichen Anwendern. Low-Code-Entwickler ermöglichen schnelle Prototypen und Automatisierungen, Softwareentwickler sorgen für skalierbare und robuste Implementierungen, während UI/UX-Designer dafür verantwortlich sind, dass die Lösungen intuitiv bedienbar und nutzerfreundlich sind. Der Einsatz von KI zum Programmieren (VIBE-Coding) kann hierbei unterstützen. Besonders in agilen Projekten ist diese enge Verzahnung zwischen Datenexperten und Implementierungsspezialisten erfolgsentscheidend.

Low Code Entwickler (m/w/d)

- Aufgabe: schnelle Entwicklung von Anwendungen und Prototypen, Erstellung von automatisierten Workflows

- Mindset: lösungsorientiert, experimentierfreudig

- Skillset: grundlegende Programmierkonzepte, Prozessmodellierung, API-Integration, Verständnis von Datenmodellen

- Tools: Microsoft Power Apps, Microsoft Power Automate, Cursor AI

Softwareentwickler (m/w/d)*

- Aufgabe: integriert Datenanalysen und KI-Modelle in bestehende Anwendungen, entwickelt APIs für den Datenzugriff

- Mindset: innovativ, lösungsorientiert, strukturiert, qualitätsbewusst

- Skillset: Softwareengineering, Programmiersprachen, Softwarearchitektur, Testing, DevOps-Praktiken

- Tools: VS Code, Git für Versionsverwaltung, Postman für REST/GraphQL APIs, CI/CD-Pipelines

(*Um die Übersicht nicht unnötig aufzublähen wird auf eine weitere Unterteilung der Softwareentwickler, z.B. in Frontend-, Backend-, Cloud- und Datenbankentwickler, Architekten, DevOps-Ingeneure, und Tester, verzichtet und es wird stattdessen von FullStack-Entwicklern ausgegangen.)

UI/UX-Design (m/w/d)

- Aufgabe: gestaltet benutzerfreundliche Oberflächen für Datenanalysen, optimiert die User Experience für datengetriebene Anwendungen, erstellt Design für intuitive Dashboards und Berichte

- Mindset: nutzerorientiert, kreativ, empathisch, kommunikativ

- Skillset: CSS-Frameworks, Responsive Design, BFSG, User-Testing

- Tools: Figma, Sketch, Miro

5. Die Schlüsselrollen für Governance und Compliance

Der Bereich Governance & Compliance gewinnt mit zunehmender Datennutzung und strengeren Regularien immer mehr an Bedeutung. Diese Rollen stellen sicher, dass alle Datenaktivitäten rechtskonform, sicher und im Einklang mit ethischen Grundsätzen und Unternehmensrichtlinien durchgeführt werden. Sie sind ein entscheidender Schutzschild gegen rechtliche und reputationsbezogene Risiken im Kontext der Datennutzung.

Der Datenschutzbeauftragte ist in vielen Unternehmen nach DSGVO und BDSG gesetzlich vorgeschrieben – ein Fehlen kann mit Bußgeldern von bis zu 10 Millionen Euro oder 2% des weltweiten Jahresumsatzes geahndet werden. Während IT-Sicherheitsbeauftragte nur in bestimmten Branchen (z.B. KRITIS) verpflichtend sind, sollten sie grundsätzlich in jedem datenverarbeitenden Unternehmen benannt werden. Data Stewards sorgen dafür, dass die Datenqualität langfristig gesichert bleibt und Datensilos vermieden werden.

Datenschutzbeauftragter (m/w/d)

- Aufgabe: Beratung von Unternehmen zu Datenschutzthemen, Überwachung der Einhaltung im Unternehmen, Folgenabschätzung, Zusammenarbeit mit Aufsichtsbehörden, Unterrichtung von Mitarbeitenden zu deren Pflichten

- Mindset: rechtsbewusst, verantwortungsvoll, unternehmerisch

- Skillset: Experte in DSGVO und BDSG, Risikobewertung, Schulungs- und Kommunikationsfähigkeiten, Pflichtqualifikationen müssen vorhanden sein

IT-Sicherheitsbeauftragter (m/w/d)

- Aufgabe: Schutz der Daten vor unberechtigtem Zugriff, Erkennung und Reaktion auf Sicherheitsvorfälle, Entwicklung und Durchsetzung von Sicherheitsrichtlinien, Regelmäßige Audits

- Mindset: sicherheitsbewusst, vorausschauend, detailorientiert, risikobewusst

- Skillset: Risikoanalyse, Netzwerk- und Systemsicherheit, Penetrationstests, Security Frameworks & Managementsysteme

Data Steward (m/w/d)

- Aufgabe: verhindert Wildwuchs, stellt die Datenqualität und -konsistenz sicher, sorgt für die Einhaltung von Datenschutz- und Compliance-Vorgaben

- Mindset: analytisch, strukturiert, vorausdenkend

- Skillset: Datenqualitätsmanagement, Metadatenverwaltung, Datenmodellierung, Domänenwissen, Compliance-Kenntnisse

Braucht mein Unternehmen wirklich all diese Rollen?

Die dargestellten Rollen decken das gesamte Spektrum der Datennutzung ab, ohne Anspruch auf Vollständigkeit. Für viele der Rollen gibt es auch synonyme Bezeichnungen im Markt.

Besonders in kleineren Unternehmen ist es üblich und oft auch sinnvoll, dass einzelne Personen mehrere Rollen innehaben. So fungieren Data-Analysten häufig auch als Datenbankspezialisten, da sie ohnehin tiefe Einblicke in die Daten benötigen. Bei kleineren Analyse- oder KI-Projekten könnte sogar eine einzelne Person ausreichend sein. Dies bringt allerdings auch Herausforderungen mit sich:

- das umfangreiche Wissen muss erst angeeignet werden

- oft gibt es keine Musterlösung, sondern es muss eine anwendungsfallspezifische Lösung erarbeitet werden, was einen vollumfänglichen Überblick über die Möglichkeiten erfordert

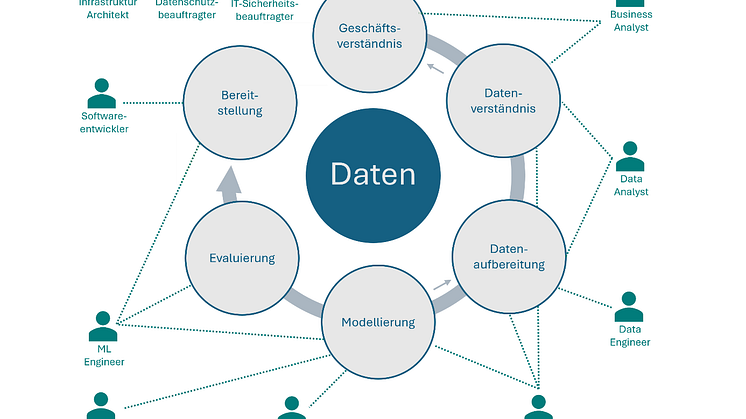

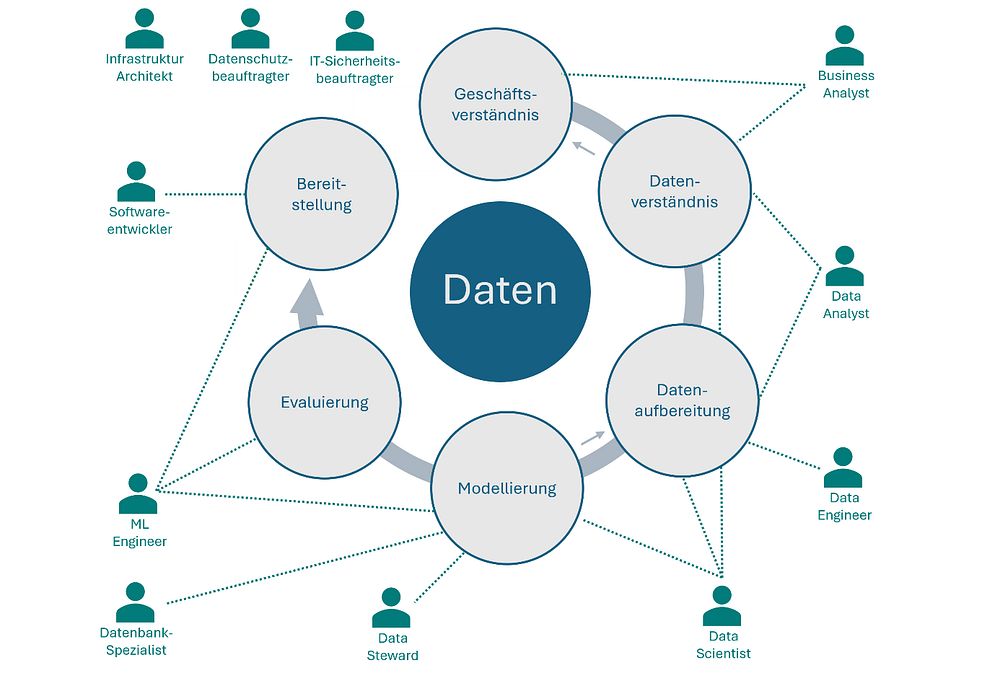

Welche Rollen in einem konkreten Fall benötigt werden, lässt sich am besten erkennen, wenn man den CRISP-DM-Prozess (Cross Industry Standard Process for Data Mining) durchgeht, der alle Phasen eines Datenanalyseprojekts von der Geschäftsverständnis-Phase bis zur Bereitstellung strukturiert abbildet:

KI in Unternehmen mit spezialisierten Fachkräften erfolgreicher einsetzen – ein Fazit

Um Big Data und KI effektiv zu nutzen, benötigt ein Unternehmen verschiedene Kompetenzen in den genannten fünf Hauptbereichen. Je nach Unternehmensgröße können diese Rollen von dedizierten Spezialisten oder von Mitarbeitern in Mehrfachfunktionen besetzt werden.

Der Schlüssel zum Erfolg liegt in einer klaren Datenstrategie und dem Aufbau einer zukunftsfähigen Datenarchitektur, die weit über Excel-Tabellen hinausgeht. Mit den richtigen Rollen und Prozessen wird die Transformation zu einem datengetriebenen Unternehmen nicht nur möglich, sondern zum entscheidenden Wettbewerbsvorteil.

Über den Autor

Thomas Bazan ist Softwareentwickler, Data Scientist und AI Enthusiast. Im Rahmen seiner Tätigkeit in der Software & Data Intelligence bei der TAS AG ist er spezialisiert auf tiefgehende Datenanalysen, die Entwicklung von digitalen Lösungen rund um die Customer Experience und darüber hinaus sowie auf den Einsatz von künstlicher Intelligenz im Unternehmenskontext.